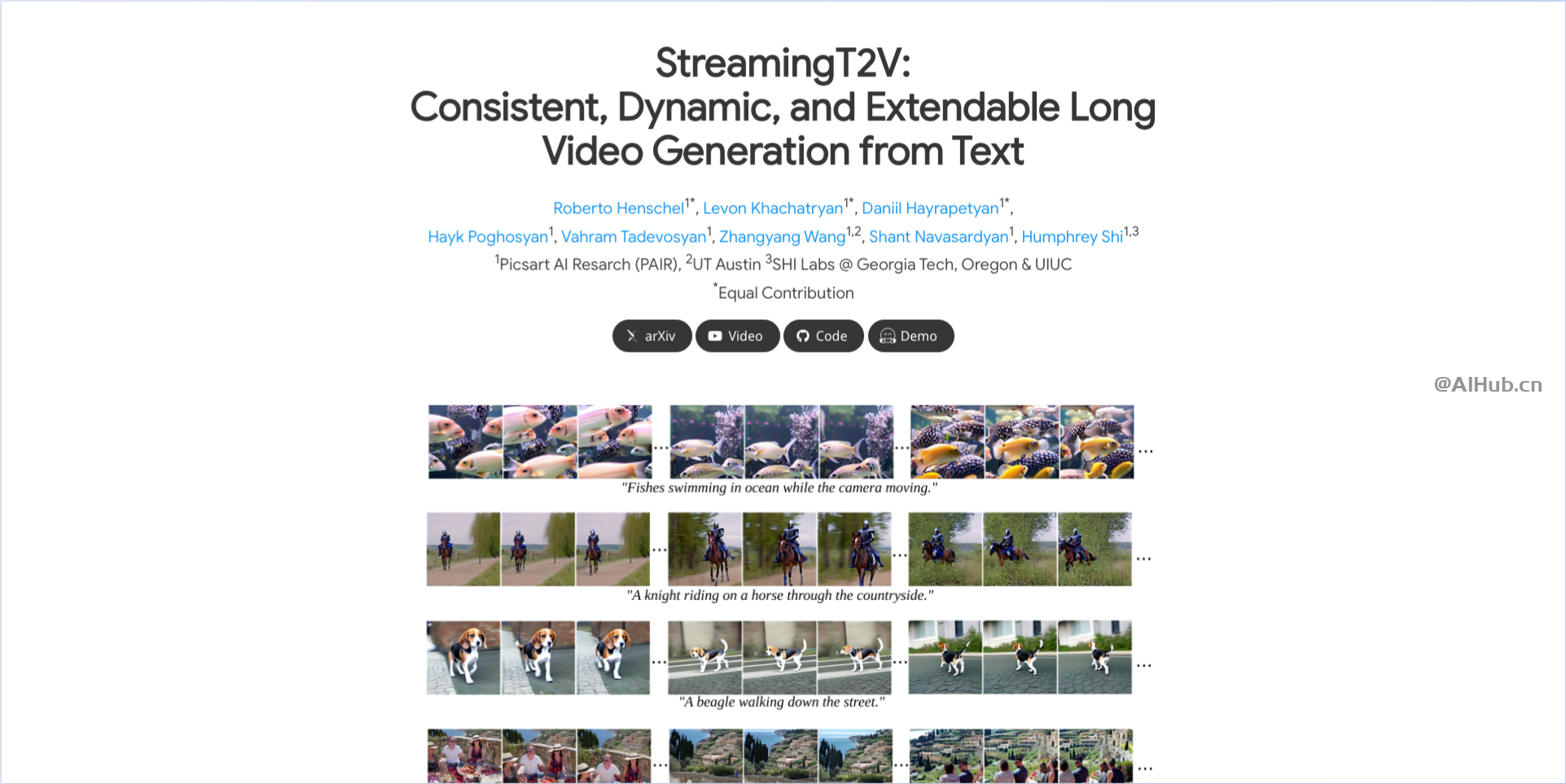

StreamingT2V是什么?

StreamingT2V是由Picsart AI Research等团队联合发布的一款创新的AI视频生成模型。它能生成长达1200帧、时长为2分钟的视频,大大超越了先前模型的时长限制,如Sora模型。StreamingT2V以其开源性和与其他模型如SVD和animatediff的兼容性,标志着AI视频生成技术的一大步进。

StreamingT2V的主要特性

- 长时长视频生成能力:StreamingT2V能够生成高达1200帧、时长为2分钟的视频,这在AI视频生成技术中是一个显著的进步,大大超越了先前模型的时长限制。

- 高质量和时间一致性:该模型专门设计来保持视频在长时间生成过程中的质量和一致性,避免了常见的视频质量下降、表现生硬或停滞等问题。

- 自回归视频生成技术:StreamingT2V采用自回归技术连续生成视频内容,允许模型在生成新的视频帧时利用已生成的帧作为参考,从而确保视频的流畅和一致性。

- 模块化设计:模型包括条件注意力模块(CAM)和外观保留模块(APM),这些模块分别负责短期和长期记忆,帮助模型在生成过程中保持细节和场景的连续性。

- 开源与兼容性:作为一个开源项目,StreamingT2V不仅可以单独使用,还可以与其他流行的视频生成模型如SVD和animatediff等无缝集成,进一步促进了开源生态系统的发展。

- 支持无限长度视频生成:虽然当前实现可生成长达2分钟的视频,但理论上模型能够生成无限长度的视频,为未来的应用提供了巨大的潜力。

StreamingT2V的应用场景

- 电影和媒体制作:StreamingT2V的长视频生成能力特别适合于电影制作和其他媒体应用,可以用于创造复杂的视频序列和预告片。

- 游戏开发:游戏开发者可以利用这一技术生成游戏内的动态场景和背景故事视频。

- 教育和训练:在教育培训领域,长视频的生成能力可以用于制作教学视频和模拟实验,提供更连续和详细的学习材料。

如何使用StreamingT2V?

StreamingT2V发布了论文,提供了代码和在线体验。相关资源地址如下:

- 论文地址:https://arxiv.org/pdf/2403.14773.pdf

- 项目地址:https://streamingt2v.github.io/

- Demo试用:https://huggingface.co/spaces/PAIR/StreamingT2V

- 开源代码:https://github.com/Picsart-AI-Research/StreamingT2V

总之,StreamingT2V的推出不仅扩展了AI视频生成的边界,还为内容创作者提供了新的工具来探索和实现更复杂的视觉叙述。

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。