MagicAnimate是什么?

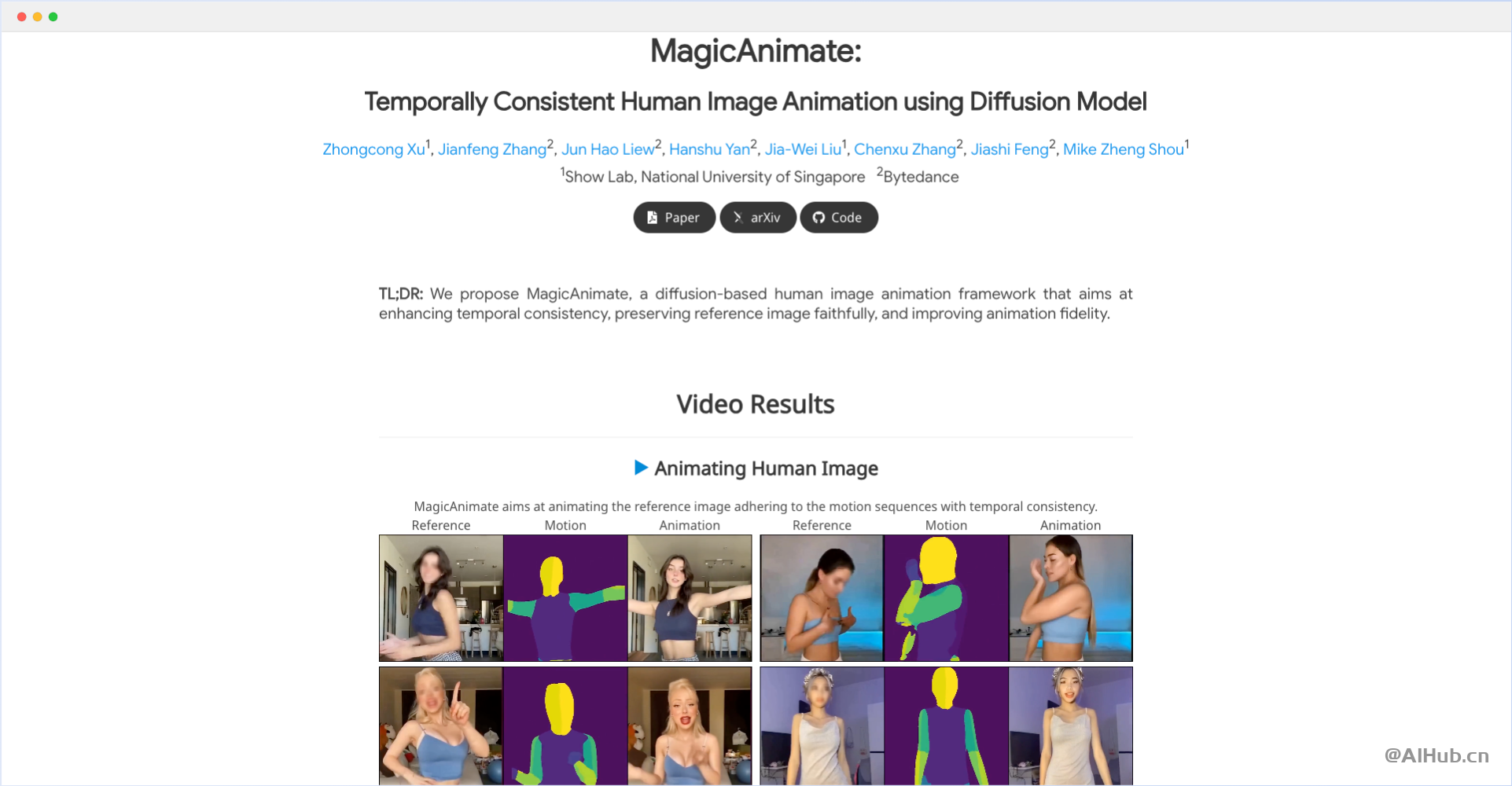

MagicAnimate是由新加坡国立大学Show Lab和字节跳动联合开发的一个项目,旨在使用扩散模型实现时间上一致的人类图像动画。这个框架的主要目标是增强时间一致性、忠实地保留参考图像,并提高动画的真实感。

- 项目地址:https://showlab.github.io/magicanimate/

- 论文:https://arxiv.org/abs/2311.16498

- GitHub:https://github.com/magic-research/magic-animate

- Huggingface在线测试:https://huggingface.co/spaces/zcxu-eric/magicanimate

MagicAnimate主要特点

MagicAnimate的主要功能和特点包括:

- 时间一致性动画: 能够根据运动序列动画化参考图像,同时保持视频帧之间的时间一致性。

- 高质量动画生成: 使用扩散模型生成逼真的人类图像动画,提高动画的真实感和视觉效果。

- 跨身份动画: 支持使用不同视频中的运动序列为参考图像制作动画,展现多样化的动画效果。

- 多种应用场景: 包括未见领域动画(如油画和电影角色动画)和结合T2I扩散模型的动画,展示广泛的应用潜力。

- 多人动画: 能够根据给定的运动序列制作包含多个人物的动画。

- 视频融合策略: 采用简单的视频融合技术,实现长视频动画的平滑过渡。

这些功能和特点使MagicAnimate成为一个强大的工具,适用于各种动画制作和创意表达需求。

MagicAnimate应用流程

MagicAnimate使用视频扩散模型和外观编码器进行时间建模和身份保持。为了支持长视频动画,它采用了一个简单的视频融合策略,在推理过程中产生平滑的视频过渡。

MagicAnimate适用人群

MagicAnimate适合AI研究人员、动画制作人员、内容创作者以及对人类图像动画技术感兴趣的技术爱好者。

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。