Phi-3 是什么?

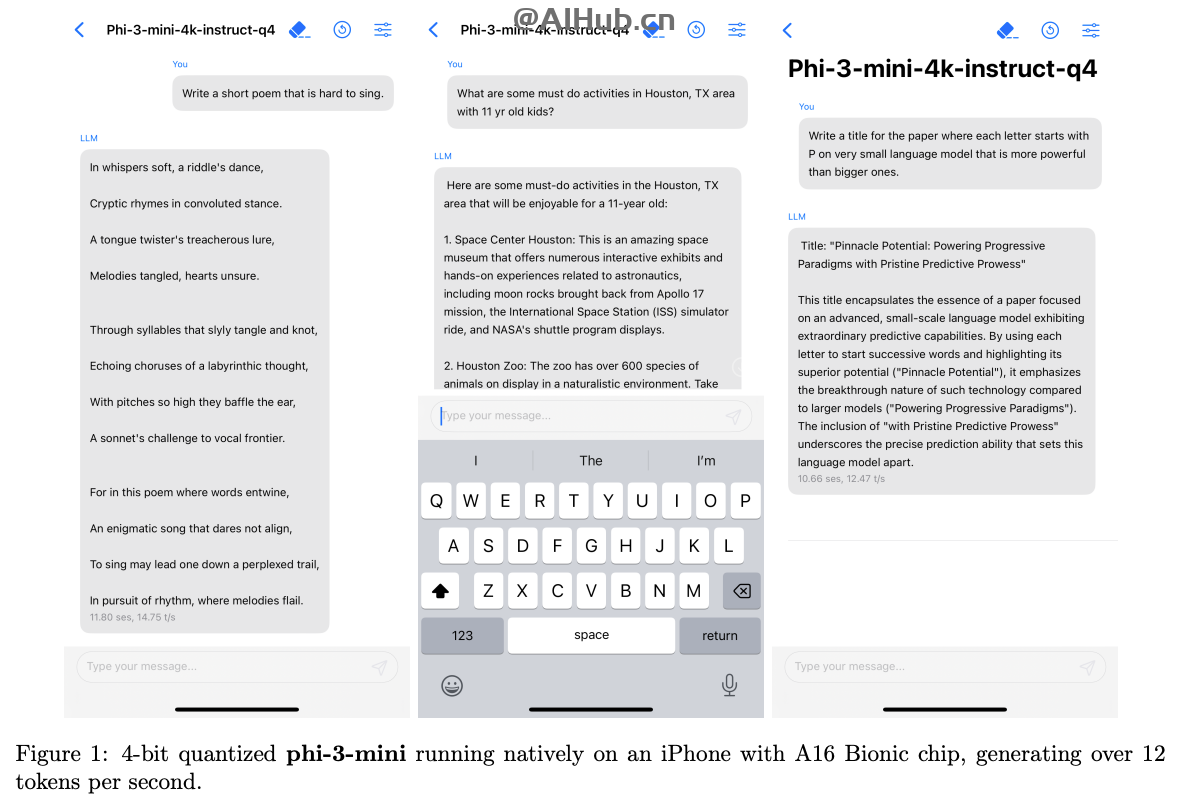

Phi-3 是微软 AI 研究院公布的一系列小型语言模型,开源可商用。Phi-3 系列包括三种模型:Phi-3-Mini、Phi-3-Small 和 Phi-3-Medium,它们在保持较小模型尺寸的同时,还能提供与大型模型相媲美的性能。这些模型特别适合于需要快速响应和低延迟的应用场景,同时还能减少对带宽和存储的需求,例如在移动设备或者边缘计算设备上。

Phi-3模型组成:

- Phi-3-mini:mini是3.8B 的参数,3.3T token 训练数据。在多个学术基准测试中,Phi-3-mini 性能接近或等同于市场上的大型模型,例如在 MMLU 测试中得分为 69%,在 MT-bench 测试中得分为 8.38 分。

- Phi-3-small:Small 是 7B 参数,4.8T token 训练数据,MMLU 75%,MT-bench 8.7 分。

- Phi-3-medium: Medium 是 14B 参数,4.8T token 训练数据,MMLU 78%,MT-bench 8.9 分。

Phi-3的模型特色和优势

- 小型化:Phi-3 模型的体积小,特别是 Phi-3-Mini,只有 3.8B 参数,这使得模型可以在资源受限的设备上运行。

- 高性能:尽管模型小型化,Phi-3 在多个学术基准测试中表现出接近或等同于市场上大型模型的性能。

- 快速响应:Phi-3-Mini 能够在 iPhone 上每秒生成 16 个 token 的信息,这意味着它可以在移动设备上实现快速响应。

- 离线能力:Phi-3 模型支持离线运行,不需要互联网连接,这有助于保护用户隐私并减少对网络带宽的依赖。

- 多语言支持:Phi-3 的 Small 和 Medium 版本包含了多语言数据,虽然 Phi-3-Mini 主要处理英文,但未来可能会支持更多语言。

- 节省资源:Phi-3 的内存占用相对较低,这使得它能够在配置较低的设备上运行,而不会显著影响设备性能。

- 易于集成:由于其小型化和高效性,Phi-3 模型可以轻松集成到各种应用中,包括移动应用、嵌入式系统和物联网设备。

- 定制应用:小型模型如 Phi-3 更适合于定制化应用,特别是对于那些数据集较小或需要特定领域优化的企业。

- 成本效益:相比于大型模型,小型模型通常在计算资源和能源消耗上更为经济,有助于降低运营成本。

- 易于部署:小型模型易于在本地设备上部署,有助于实现快速的数据处理和响应,同时减少对云服务的依赖。

Phi-3 模型的这些优势使其成为在资源受限或需要快速、本地化处理的自然语言处理应用中的理想选择。

Phi-3的技术框架

- Transformer 解码器架构:Phi-3-Mini 采用了为移动设备优化的架构,支持通过 LongRope 系统扩展上下文长度。

- 结构设计:Phi-3-Mini 与 Llama-2 模型结构相似,使用了相同的分词器,保证了与 Llama-2 系列软件包的兼容性。

- 分组查询和块状稀疏注意力机制:Small 和 Medium 版本引入了这些机制,以优化长期上下文检索性能并减少内存占用。

- 数据训练:使用网页数据和合成数据进行训练,分为两个阶段,第一阶段注重通用知识和语言理解,第二阶段培养逻辑推理和特定技能。

- 训练方法:Phi-3 的训练方法受到儿童学习方式的启发,采用“课程”式训练,使用简化的“儿童读物”来教导模型。

如何使用Phi-3?

微软提供了Phi-3的技术报告、在线体验和模型下载地址:

- 在线体验地址:https://huggingface.co/chat/models/microsoft/Phi-3-mini-4k-instruct

- 模型下载地址:https://huggingface.co/collections/microsoft/phi-3-6626e15e9585a200d2d761e3

- 技术报告链接:https://arxiv.org/abs/2404.14219

总之,Phi-3 系列模型的推出,展示了微软在小型化、高效能语言模型领域的最新进展,特别是在移动设备上的应用潜力。

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。