MuseV是什么?

MuseV是一个由腾讯音乐娱乐的天琴实验室开源的虚拟人视频生成框架,专注于生成高质量的虚拟人视频和口型同步。它利用先进的算法,能够制作出具有高度一致性和自然表情的长视频内容。MuseV支持自定义动作和风格,视频时长理论上无限,且生成速度快。这一技术在AI创作领域中表现出色,为虚拟人视频制作提供了新的可能性。

MuseV的主要特性

MuseV的主要特性包括:

- 图生视频和口型生成:MuseV能够根据图像生成视频,并同步口型,适用于创建虚拟人物视频内容。

- 高一致性:生成的视频在画面和表情上保持高度一致性,使得虚拟人物看起来更自然和真实。

- 无限视频时长:采用新算法Parallel Denoising,理论上可以生成无限时长的视频,突破了以往模型的时间限制。

- 自定义动作:支持通过Openpose技术自定义动作生成,提供更大的创作自由度。

- 口型驱动技术:MuseV的口型生成技术(MuseTalk)准确自然,即将开源,进一步提升虚拟人物的语言表达能力。

- 多风格适应性:无论是写实风格还是二次元风格,MuseV都能生成效果稳定的视频。

- 快速视频生成:与其他模型相比,MuseV在视频生成速度上有显著优势,能够更快速地输出视频内容。

这些特性使MuseV成为一个强大的工具,适用于多种虚拟人物视频制作场景,如娱乐、教育、游戏和社交媒体等。

如何使用MuseV?

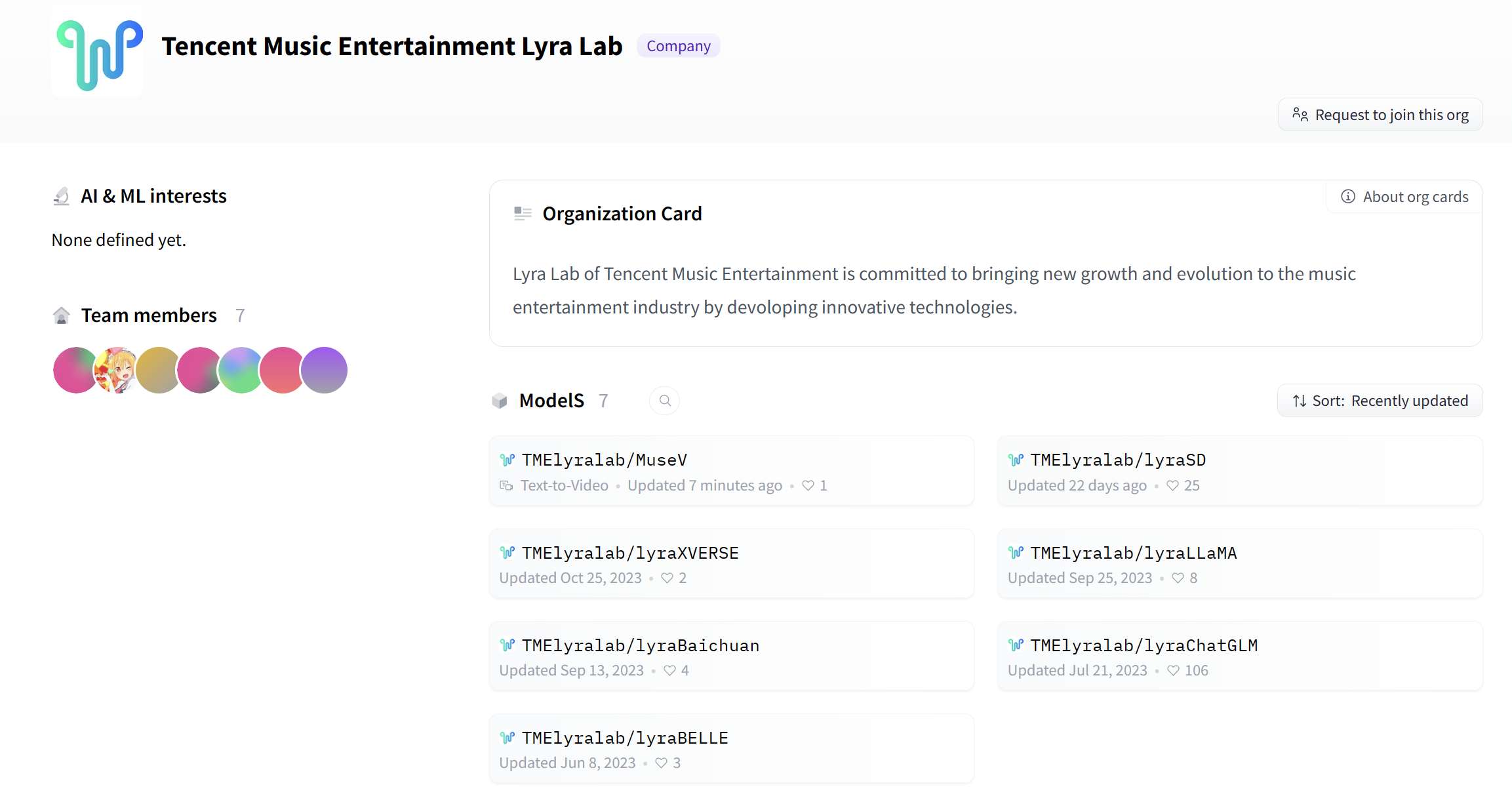

天琴实验室正式发布了开源模型MuseV,现阶段支持图生视频和口型生成,可以丝滑生成虚拟人视频,目前可以在Hugging Face和github上直接拉取代码模型跑起来。

项目地址:

- GitHub:https://github.com/TMElyralab/MuseV

- HuggingFace:https://huggingface.co/TMElyralab/MuseV

MuseV的开源是一个重要的里程碑,它不仅为AI图生视频领域带来了新的可能性,也为社区共建和进一步的技术进步提供了基础。天琴实验室表示,开源只是一个开始,他们将继续追求更高的技术水平,并期待更多团队参与到开源共建中来。

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。