Mistral NeMo是什么?

Mistral NeMo是由法国AI公司Mistral AI与NVIDIA合作开发的一个120亿(12B)参数的小语言模型。它提供高达128k tokens的上下文窗口,并且在推理、世界知识和编码准确性方面达到了该规模模型的先进水平。它使用标准架构,易于集成和使用,并且可以作为Mistral 7B的直接替代品。

Mistral NeMo的主要特性

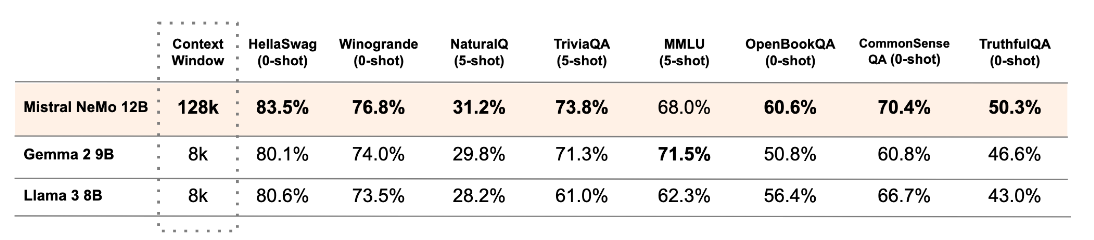

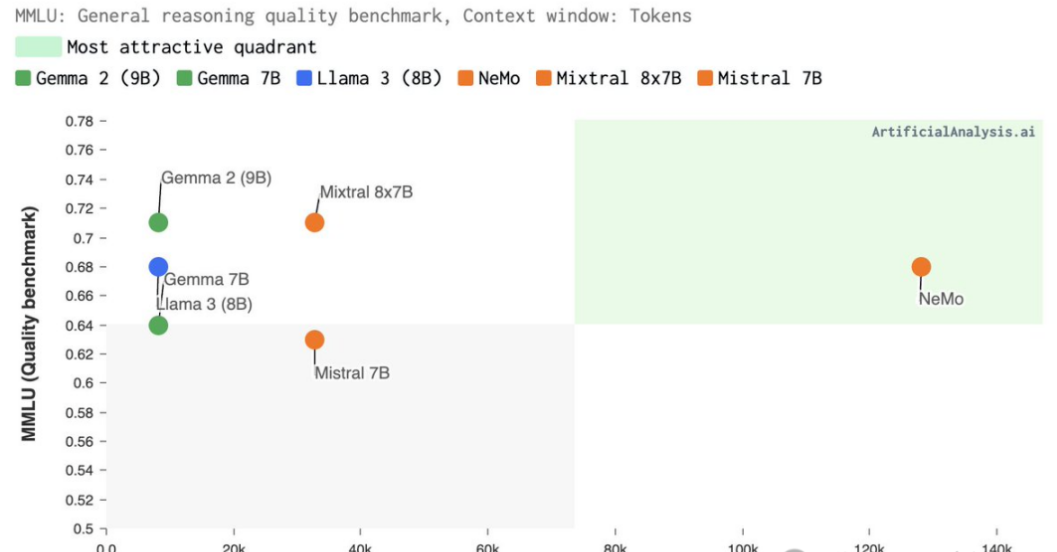

- 性能卓越:与同等参数规模模型相比,它的推理、世界知识和编码准确性都处于领先地位。

- 大上下文窗口:Mistral NeMo支持128K上下文,能够更加连贯、准确地处理广泛且复杂的信息,确保输出与上下文相关。

- 多语言支持:专为全球多语言应用设计,支持包括中文、英语、法语、德语、西班牙语、意大利语、葡萄牙语、日语、韩语、阿拉伯语和印地语在内的多种语言。

- 指令微调:Mistral NeMO 经历了高级微调和调整阶段。与 Mistral 7B 相比,它在遵循精确指令、推理、处理多轮对话和生成代码方面表现得更好。

- 开源许可:Mistral在Apache2.0许可证下发布了预训练的基本检查点和指令微调检查点,允许商用。

Mistral NeMo的性能评测

除了在MMLU基准上,Mistral NeMo不如Gemma 2 9B。但在多轮对话、数学、常识推理、世界知识和编码等基准中,超越了Gemma 2 9B和Llama 3 8B。

如何使用Mistral NeMo?

Mistral NeMo权重文件已托管在HuggingFace上,提供了基础模型和指令模型,可以通过mistral-inference试用,并用mistral-finetune适配。

- 基础模型:https://huggingface.co/mistralai/Mistral-Nemo-Base-2407

- 指令模型:https://huggingface.co/mistralai/Mistral-Nemo-Instruct-2407

另外,用户可以通过ai.nvidia.com作为NVIDIA NIM体验Mistral NeMo,可下载的NIM版本即将推出。