-

Step-1X:阶跃星辰推出的文生图AI大模型

Step-1X是阶跃星辰推出的文生图大模型,具备强大的图像生成能力,它能够通过输入的文本描述生成高质量、高分辨率的图像,特别擅长处理和理解中文文本。该模型使用自研的DiT架构,具备深度语义理解和细节捕捉能力,能够将复杂的文本语义转化为图像特征,生成与描述高度匹配的视觉内容。此外,Step-1X 还支持风格迁移,使其在广告创意、游戏美术、影视制作等领域的应用更为广泛。 -

SkyReels-V1:昆仑万维开源的AI短剧创作视频生成模型

SkyReels-V1 是昆仑万维开源的中国首个面向AI短剧创作的视频生成模型,专注于影视级人物表演、表情生成和动作模拟。它能够精细控制人物的口型、表情和肢体动作,提供33种人物微表情和400多种自然动作组合,模拟真实的情感表达。 -

QwQ-Max-Preview:阿里通义千问推出的深度思考模型

QwQ-Max-Preview是阿里Qwen团队基于Qwen2.5-Max开发的推理模型预览版,擅长深度推理、数学、编程和AI智能体任务,未来将开源并推出正式版。 -

文心大模型4.5:百度推出的新一代原生多模态基础大模型

文心大模型4.5是百度推出的新一代原生多模态基础大模型,通过多个模态联合建模实现协同优化,多模态理解能力优秀;具备更精进的语言能力,理解、生成、逻辑、记忆能力全面提升,去幻觉、逻辑推理、代码能力显著提升。 -

CogView4 - 智谱推出的开源文生图模型,支持汉字生成

CogView4是北京智谱华章推出的开源文生图模型,支持中英双语输入,擅长生成含汉字图像。它在DPG-Bench测试中排名第一,性能卓越。具备任意分辨率生成和长提示词输入能力,技术领先,遵循Apache 2.0协议,适用于广告、短视频等创意领域。 -

协和·太初 - 北京协和医院和中科院联合推出的罕见病领域 AI 大模型

“协和・太初”是由北京协和医院和中国科学院自动化研究所共同研发的国内首个罕见病领域 AI 大模型。该模型基于我国罕见病知识库的多年积累和中国人群基因检测数据,是国际首个符合中国人群特点的罕见病大模型。 -

-

-

讯飞星火开源大模型

讯飞星火开源大模型是科大讯飞对外开源的大模型。讯飞星火开源-13B(iFlytekSpark-13B)拥有130亿参数,在经过累计超过3万亿以上tokens海量高质量数据集上进行预训练,然后在精调的多元化对齐数据上进行微调得到。iFlytekSpark-13B在多个标准评估中展现出了卓越的性能,其表现优于同参数量级的开源模型,与一些闭源模型相比不相上下。 -

Stable Video Diffusion-Stability AI推出的首个开放式生成AI视频模型

Stable Video是Stability AI推出的首个开放式生成AI视频模型。这个模型旨在服务于媒体、娱乐、教育、营销等多个领域的广泛视频应用。它赋予个人将文本和图像输入转化为生动的场景的能力,并将概念提升为现场动作、电影般的创作。 -

MiniMax-01:MiniMax推出的开源AI模型,400万超长上下文,性能比肩GPT-4o

MiniMax-01是一个先进的大型语言模型系列,包括MiniMax-Text-01和MiniMax-VL-01。这些模型通过闪电注意力机制和混合专家架构,能够高效处理长达400万个token的上下文窗口,在多个标准和内部基准测试中表现出色,特别是在长上下文处理方面显著优于其他顶级模型。 -

-

Qwen2.5-1M:阿里推出的开源AI模型,支持100万Token上下文

Qwen2.5-1M是阿里巴巴Qwen团队发布的支持100万Token上下文的开源语言模型系列,包括Qwen2.5-7B-Instruct-1M和Qwen2.5-14B-Instruct-1M。它们结合了基于vLLM的推理框架和稀疏注意力机制,显著提升了处理长文本时的速度和效率。该模型在长上下文任务中表现优异,特别是在密钥检索等复杂任务中,超越了之前的Qwen2.5-Turbo和GPT-4o-mi… -

EchoMimicV2 - 蚂蚁推出的开源AI数字人模型,音频驱动人物动作生成逼真动态角色

EchoMimicV2 是蚂蚁集团开发的音频驱动的AI数字人生成模型,利用音频输入轻松驱动人物动作,打造超逼真、富有表现力的动态角色。 -

-

ModelScope魔搭-阿里机器学习模型平台

ModelScope是阿里达摩院发布的汇聚各领域先进的机器学习模型的平台,提供模型探索体验、推理、训练、部署和应用的一站式服务。在这里,你可以共建模型开源社区,发现、学习、定制和分享你心仪的模型。 -

GPT-4o:OpenAI最新发布的多模态AI大模型,可实时推理音频、视觉和文本

GPT-4o是OpenAI推出的最新一代大型语言模型,它集合了文本、图片、视频、语音的全能模型,能够实时响应用户需求,并通过语音进行实时回答。GPT-4o具有强大的逻辑推理能力,其速度是前代模型GPT-4 Turbo的两倍,而成本降低了50%。 -

QVQ-72B-Preview:阿里通义推出的开源多模态推理模型

QVQ-72B-Preview 是由阿里通义团队开发的一款多模态视觉推理模型,基于 Qwen2-VL-72B 微调,拥有 73.4B 参数,专注于复杂的视觉理解和跨学科推理任务。QVQ不但能感知更准确的视觉内容,并据此作出更细致的分析推理,还会质疑自身假设,仔细审视其推理过程的每一步,经过深思熟虑后给出最后结论。 -

Meta Movie Gen:Meta推出的AI视频音频生成模型

Meta Movie Gen是由Meta推出的AI视频音频生成模型,能够通过简单的文本输入生成高质量的视频和音效,还支持精准的视频编辑。用户可以输入文本描述生成高清视频、上传图像制作个性化视频,或根据指令修改视频内容。Movie Gen 还可以生成与视频同步的背景音乐和音效,适合内容创作者、电影制作人等使用。 -

中国电信公布 TeleChat 大模型,宣称将建立“百亿级 AI 服务商”

2023 全球数字经济大会人工智能高峰论坛上,中国电信集团数字智能科技分公司副总经理张鑫公布中国电信版 ChatGPT 产品 TeleChat 大模型。 -

-

SeedFoley - 字节跳动推出的AI视频音效生成模型

SeedFoley 是字节跳动推出的端到端视频音效生成模型,通过融合时空视频特征和扩散生成模型,实现音效与视频的高度同步。它支持可变长度视频输入,可在音效准确性、同步性和匹配度上达到领先水平。SeedFoley 已上线即梦应用,用户可一键生成专业级音效,广泛应用于 AI 视频创作、Vlog、短片和游戏制作等场景,提升视频的沉浸感和专业感。 -

Audiobox-Meta推出的新一代音频生成模型

Audiobox是Meta发布的一款基于语音和自然语言提示生成音频的先进研究模型。通过结合语音输入和文本提示,Audiobox可以轻松生成各种声音,包括语音、音效和音景,从而为多种用例提供定制音频。 -

-

Qwen2-VL:阿里最新开源的视觉多模态大语言模型

Qwen2-VL是由阿里巴巴最新开源的视觉多模态大语言模型系列,专注于视觉语言的理解和处理。该模型能够处理不同分辨率和比例的图像,并具备对20分钟以上视频内容的理解能力。测试数据显示,其72B模型在大多数指标上超过了OpenAI的GPT-4o和Anthropic的Claude3.5-Sonnet等知名闭源模型,成为目前最强的多模态模型之一。 -

Llama中文社区

Llama中文社区是中国最大的开源技术社区,开放了一系列尺寸的大模型。基于当前最优秀的开源模型Llama2,使用主流Decoder-only的标准Transformer网络结构,支持32K的上下文长度(Context Length),为同尺寸模型中最长,能满足更长的多轮对话、知识问答与摘要等需求,模型应用场景更广泛。 -

星火深度推理模型X1

星火深度推理模型X1是科大讯飞推出的首个具备深度思考和推理能力的大型AI模型。它基于全国产算力训练,拥有较高的数学能力和推理能力,能够在较少算力的情况下提供业界领先的效果,并成功实现了在实际场景中的应用。 -

EMO-阿里巴巴发布的AI肖像视频生成框架

EMO是一个由阿里巴巴发布的音频驱动的肖像视频生成框架。它能够通过单一参考图像和音频输入,生成具有丰富表情和多样头部姿势的虚拟角色视频。EMO利用先进的注意力机制和去噪网络,支持多语言和多种肖像风格的动态表现,为内容创作和虚拟角色动画制作提供了新工具。 -

心辰Lingo:西湖心辰推出的端到端语音大模型

心辰Lingo大模型是由西湖心辰开发的一款端到端语音大模型,集成了语音识别、自然语言处理、意图识别和语音合成等功能,能够深度理解用户的语音内容和情感,为用户提供自然、生动的互动体验。Lingo不仅可以快速响应复杂指令,还能根据语境和情感自适应调整语音表达方式,重新定义了智能语音交互的体验。 -

-

Gemini-谷歌发布的多模态AI大模型

AIHub 12 月 6 日消息,谷歌宣布推出其认为规模最大、功能最强大的人工智能多模态AI模型 Gemini。意味着它可以理解、操作和结合不同类型的信息,包括文本、代码、音频、图像和视频。 -

-

-

-

OpenAI o3:OpenAI最新推出的高性能AI推理模型

o3 是 OpenAI 最新推出的高性能 AI 推理模型,专注于数学推理、编程和科学问题解决,首次在多个领域超越人类专家水平。在数学竞赛和编程任务中表现卓越,支持复杂任务的透明推理和代码生成。此外,轻量版 o3Mini 提供高效、低成本的解决方案。o3 的发布标志着 AI 技术迈向更高智能的里程碑,适用于研究、开发和教育等多领域应用。 -

Claude 3.7 Sonnet:Anthropic 最新推出的混合推理AI模型

Claude 3.7 Sonnet 是 Anthropic 公司推出的一款先进的人工智能模型,具备强大的推理和编码能力。它结合了即时响应与深度思考模式,用户可通过 API 控制思考时间,以平衡速度和回答质量。此外,它在数学、物理、指令遵循和软件开发等任务上表现出色,尤其在编码和前端开发方面有显著提升。 -

讯飞星火语音大模型

讯飞星火认知大模型是科大讯飞推出的AI大语言模型,专注于提供高精度的语音识别和超拟人化的语音合成服务。它支持多种语言和方言,具备自动语种判断和智能标点功能,能够实现流畅的语音转文字和自然口语的语音输出。该模型适用于语音搜索、聊天输入、游戏娱乐、人机交互、智能客服等多个场景,为企业和开发者提供了强大的语音交互解决方案。 -

Seaweed-字节跳动推出的AI视频生成模型

Seaweed是字节跳动推出的豆包视频生成模型,支持两种视频生成方式:文生视频和图生视频。该技术基于Transformer结构,利用时空压缩的潜空间进行训练,模型原生支持多分辨率生成,适配横屏、竖屏,并能够根据用户输入的高清图像分辨率进行适配和保真。默认输出为720p分辨率、24fps、时长5秒,并可动态延长至20-30秒。 -

HAI-腾讯云AI应用开发平台

腾讯云HAI是一款面向AI、科学计算的GPU应用服务产品,提供即插即用的澎湃算力与常见环境。助力中小企业及开发者快速部署LLM、AI作画、数据科学等高性能应用,原生集成配套的开发工具与组件,大幅提高应用层的开发生产效率。可帮你在10分钟内开发专属AI应用。 -

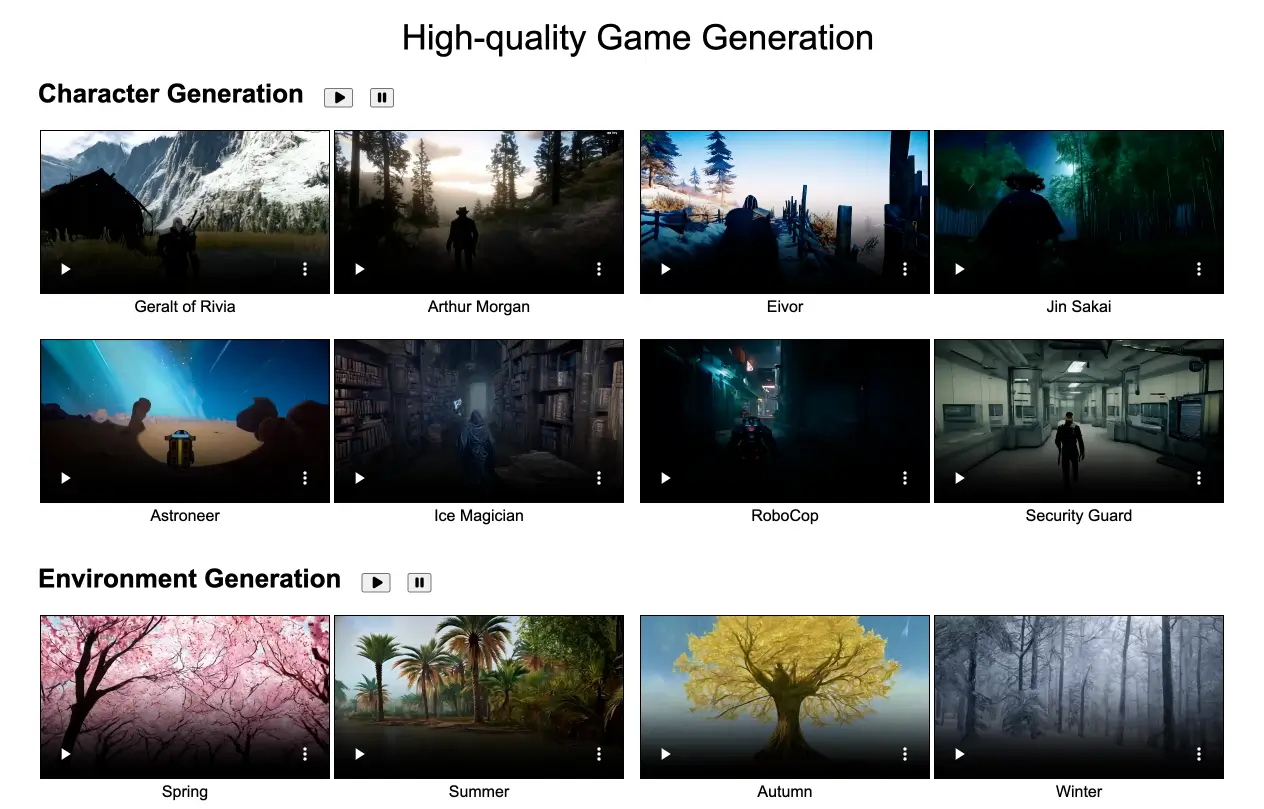

GameGen-O:腾讯推出的视频游戏生成模型,支持生成角色、环境和动作等

GameGen-O是腾讯推出的一款专门用于生成开放世界视频游戏的AI模型,它能够模拟游戏引擎功能,生成游戏角色、动态环境、复杂动作和事件,并支持互动控制。用户可以通过文本、操作信号和视频提示来实时控制游戏内容。GameGen-O 的推出标志着游戏开发进入了AI辅助的新阶段,简化了许多复杂的开发环节,降低了开发成本,甚至让普通用户也能轻松生成高质量的游戏内容。