2月5日 消息:CodeFuse-VLM是一个支持多种视觉模型和语言大模型的框架,用户可以根据自己的需求搭配不同的Vision Encoder和LLM。

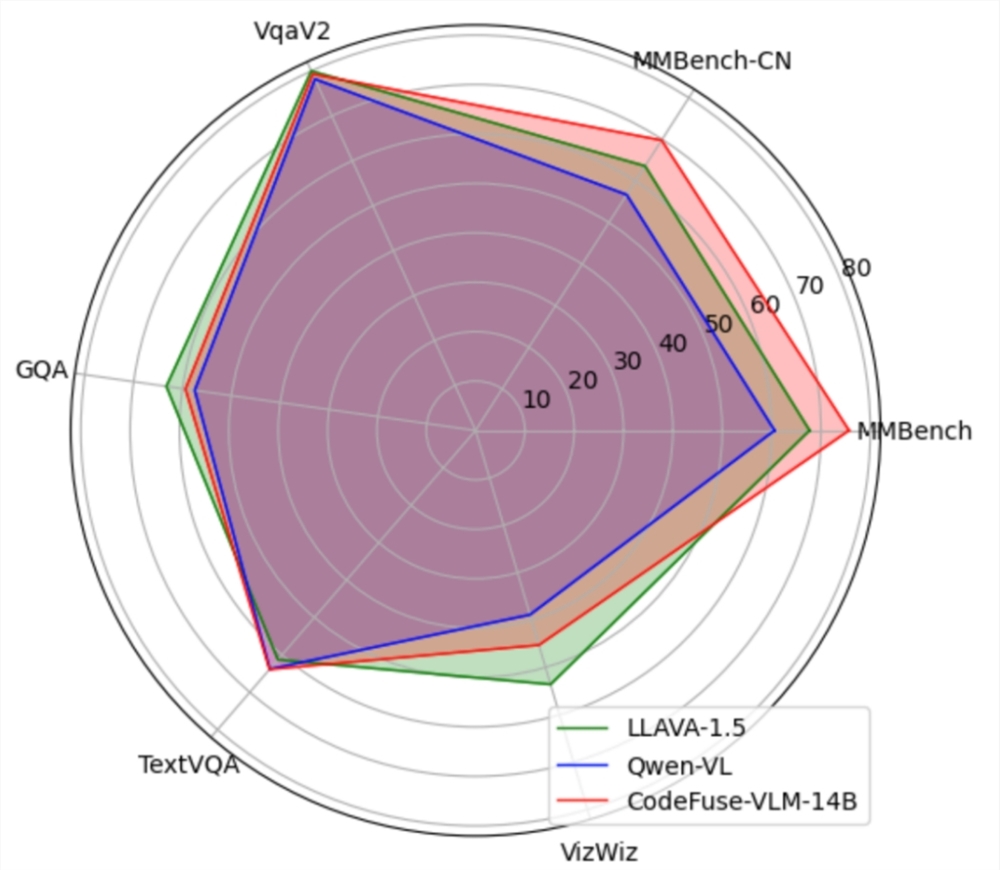

CodeFuse-VLM-14B模型在多个通用和代码任务上的性能超过LLAVA-1.5和Qwen-VL。

该框架还支持高效的PEFT微调,能有效提升微调训练速度并降低对资源的需求。

此外,CodeFuse-VLM还被用于训练网页图片到前端代码的多模态大模型,提高了前端工程师的开发效率。

CodeFuse-MFT-VLM 项目地址:

https://github.com/codefuse-ai/CodeFuse-MFT-VLM

CodeFuse-VLM-14B模型地址:

https://modelscope.cn/models/ss41979310/CodeFuse-VLM-14B/files

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。