AIHub获悉,近日,上海人工智能实验室联合商汤科技 SenseTime、香港中文大学、上海交通大学共同发布新一代通用视觉技术体系“书生”(INTERN),该体系旨在系统化解决当下人工智能视觉领域中存在的任务通用、场景泛化和数据效率等一系列瓶颈问题。

基于“书生”的通用视觉开源平台 OpenGVLab 也将在明年年初正式开源,向学术界和产业界公开预训练模型及其使用范式、数据系统和评测基准等。

任务通用和数据学习效率是制约当前人工智能发展的核心瓶颈问题。

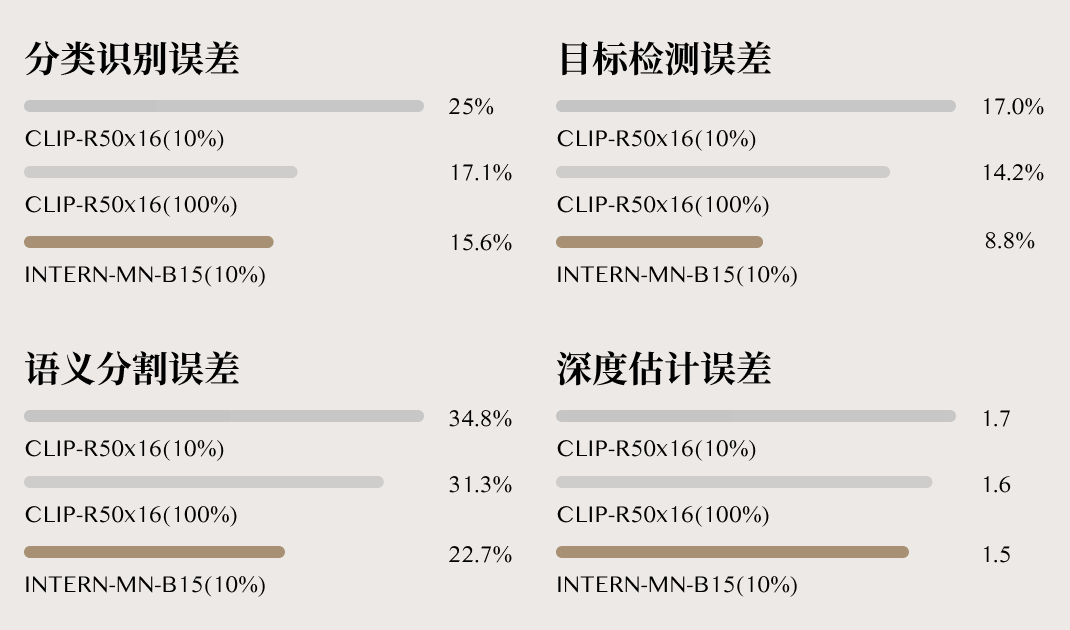

根据相关技术报告,一个“书生”基模型即可全面覆盖分类、目标检测、语义分割、深度估计四大视觉核心任务。

在 ImageNet 等 26 个最具代表性的下游场景中,书生模型广泛展现了极强的通用性,显著提升了这些视觉场景中长尾小样本设定下的性能。

相较于当前最强开源模型(OpenAI 于 2021 年发布的 CLIP),“书生”在准确率和数据使用效率上均取得大幅提升。

具体而言,基于同样的下游场景数据,“书生”在分类、目标检测、语义分割及深度估计四大任务 26 个数据集上的平均错误率分别降低了 40.2%、47.3%、34.8%和 9.4%。

“书生”在数据效率方面的提升尤为令人瞩目:只需要 1/10 的下游数据,就能超过 CLIP 基于完整下游数据的准确度,例如在花卉种类识别 FLOWER 任务上,每一类只需两个训练样本,就能实现 99.7%的准确率。

书生(INTERN)技术体系可以让 AI 模型处理多样化的视觉任务

书生(INTERN)技术体系可以让 AI 模型处理多样化的视觉任务

通用视觉技术体系“书生”(INTERN)由七大模块组成,包括通用视觉数据系统、通用视觉网络结构、通用视觉评测基准三个基础设施模块,以及区分上下游的四个训练阶段模块。

书生作为中国古代读书人的经典形象,代表着一个通过不断学习、不断成长进而拥有各方面才能的人格化角色:从基础的知识技能学习开始,到对多种专业知识触类旁通,进而成长为拥有通用知识的通才。

将全新的通用视觉技术体系命名为“书生”,意在体现其如同书生一般的特质,可通过持续学习,举一反三,逐步实现通用视觉领域的融会贯通,最终实现灵活高效的模型部署。

当前的 AI 系统开发模式下,一个 AI 模型往往只擅长处理一项任务,对于新场景、小数据、新任务的通用泛化能力有限,导致面对千变万化的任务需求时,须独立开发成千上万种 AI 模型。

同时,研究人员每训练一个 AI 模型,都需构建标注数据集进行专项训练,并持续进行权重和参数优化。

这种低效的学习训练方法,导致人力、时间和资源成本居高不下,无法实现高效的模型部署。

“书生”的推出能够让业界以更低的成本获得拥有处理多种下游任务能力的 AI 模型,并以其强大的泛化能力支撑智慧城市、智慧医疗、自动驾驶等场景中大量小数据、零数据等样本缺失的细分和长尾场景需求。

通用视觉技术体系“书生”(INTERN)由七大模块组成,包括 3 个基础设施模块、4 个训练阶段模块

通用视觉技术体系“书生”(INTERN)由七大模块组成,包括 3 个基础设施模块、4 个训练阶段模块

随着人工智能赋能产业的不断深入,人工智能系统正在从完成单一任务向复杂的多任务协同演进,其覆盖的场景也越来越多样化。

在自动驾驶、智能制造、智慧城市等众多的长尾场景中,数据获取通常困难且昂贵,研发通用人工智能模型,对于降低数据依赖尤为重要。而突破“工业应用红线”的模型,需满足同时完成多任务、覆盖大量长尾场景,且基于下游小样本数据进行再训练等要求。

借助“书生”通用视觉技术体系,业界可凭借极低的下游数据采集成本,快速验证多个新场景,对于解锁实现人工智能长尾应用具有重要意义。

商汤科技研究院院长王晓刚表示,“‘书生’通用视觉技术体系是商汤在通用智能技术发展趋势下前瞻性布局的一次尝试,也是 SenseCore 商汤 AI 大装置背景下的一次新技术路径探索。

‘书生’承载了让人工智能参与处理多种复杂任务、适用多种场景和模态、有效进行小数据和非监督学习并最终具备接近人的通用视觉智能的期盼。

希望这套技术体系能够帮助业界更好地探索和应用通用视觉 AI 技术,促进 AI 规模化落地。”